從生成語言學到自然語言處理(一):LLM和人類一樣嗎?

現在的生成式人工智慧能做到的事情越來越多,也越做越好。像是ChatGPT這樣的大型語言模型應用,從一般的問答、文章翻譯、摘要到檢查,甚至程式碼的撰寫,都能幫上忙。而身為語言學研究所的學生,我對於機器和資訊系統學習人類語言這件事情感到驚奇之餘,也很好奇 LLM 和人類在「語言知識的儲存表徵與運用機制」的差異究竟在哪裡?

在本月〈言來如此〉科技應用專欄中,本篇文章將先簡要介紹作者於書中第一篇〈ChatGPT 在做什麼?它為何能做到這些?〉中,針對 ChatGPT 運作本質及隨機性的核心觀察。而因為本文重點放在ChatGPT與語言學的關聯,內容將會略過有關大型語言模型訓練原理、過程以及神經網路技術相關的內容。接著,我會分享對於書中所提到「將自然語言轉換為計算語言」這個過程的想法並進一步討論它如何與語言學產生有意思的呼應。同樣地,此節內容將聚焦於Wolfram | Alpha 和語言學之間可能產生的連結,而不深入涉及語言學相關的理論和技術。

在本月 (以及下一個月)〈言來如此〉科技應用專欄中,本篇文章將先簡要介紹作者於書中第一篇〈ChatGPT 在做什麼?它為何能做到這些?〉中,針對 ChatGPT 運作本質及隨機性的核心觀察。而因為本文重點放在ChatGPT與語言學的關聯,內容將會略過有關大型語言模型訓練原理、過程以及神經網路技術相關的內容。接著,我會分享對於書中所提到「將自然語言轉換為計算語言」這個過程的想法並進一步討論它如何與語言學產生有意思的呼應。同樣地,此節內容將聚焦於Wolfram | Alpha 和語言學之間可能產生的連結,而不深入涉及語言學相關的理論和技術。

「It's our choices, Harry, that show what we truly are, far more than our abilities.」這是《哈利波特》中,在哈利波特疑惑著自己為什麼進到葛萊芬多學院時,鄧不利多對哈利所說的話,意思是「決定我們成為什麼樣人的,不是我們的能力,而是我們的選擇。」大學四年級,我在中文系的「中國思想史」課堂上,當時的老師也曾經對著台下作為學生的我們提到,之所以會坐在那門課堂上,其實是一種選擇。

大型語言模型 (LLMs) 在自然語言處理 (NLP) 領域取得了顯著的技術突破。然而,在其廣泛應用的背後,存在著一個核心問題:LLMs 是否能在所有語言中保持一致的表現?特別是對於「低資源語言」而言,LLMs 的表現及困境仍然是亟待探討的重要課題。

大型語言模型 (LLMs) 在自然語言處理 (NLP) 領域取得了顯著的技術突破。然而,在其廣泛應用的背後,存在著一個核心問題:LLMs 是否能在所有語言中保持一致的表現?特別是對於「低資源語言」而言,LLMs 的表現及困境仍然是亟待探討的重要課題。

在過去,人文學科往往依賴於小規模文本的精讀與詮釋。研究者透過細膩的閱讀、比較與理論架構來理解語言與文化。然而,隨著數位化與科技發展,語言學研究也迎來了新的可能性。大量文本能以「語料庫」的形式被蒐集、整理,並透過電腦工具進行處理與分析。這樣的轉變不只是技術性的革新,更是人文研究的一次「進化」。

從語言學與人工智慧的交會中,我看見了語言結構知識在實務應用上的潛力。這樣不同視角的討論不僅開闊了我的學習視野,也深化了我對語言學在 AI 發展中所能扮演角色的理解。

你覺得語言的本質是什麼?還記得在語言學概論的第一堂課,討論這個問題時,許多人(包括我)都覺得:「語言是溝通的工具」。巨觀來看,語言確實是溝通的橋樑,但這篇文章將透過尼加拉瓜手語誕生的歷程,揭示人類發展出語言的能力或許不是為了溝通,而是為了創造更多組合。而這樣的發現,也許能引出更深一層的思考:若語言天生傾向於創造,那麼人類的本質,會不會也是?

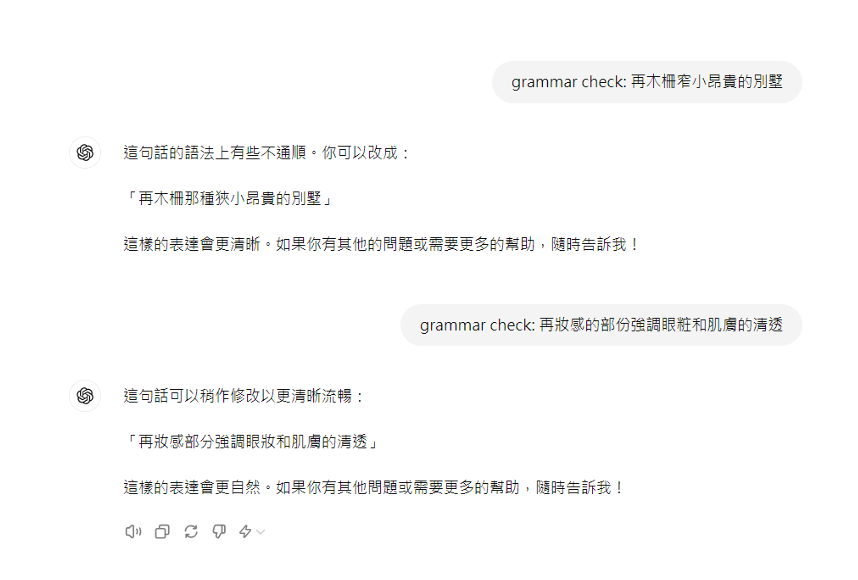

我們進行這個實驗並不是想表達 LLM 不好,而是想實際應用簡單的語言學知識,驗證這些形式化的分析是否真的能實現「在接受這麼少的前提的情況下,知道這麽多」的效果。我們的實驗成果顯示 pyLiteracy 在文法檢查這類小型 NLP 任務中的表現十分出色。最重要的是,仰賴更貼近人類對語言的理解方式,它能用相比於 LLM 而言,非常非常少的資源就完成任務,在這個專案中,我們用非常非常少的語言學知識就省下了非常多的資源。